-

效果演示,支持显示思考内容,思考时间,可以折叠思考内容

一、将ChatAI更新到0.2.3.alpha0202及之后版本

- 在MN Utils中更新:

通过以下几种方式调用

-

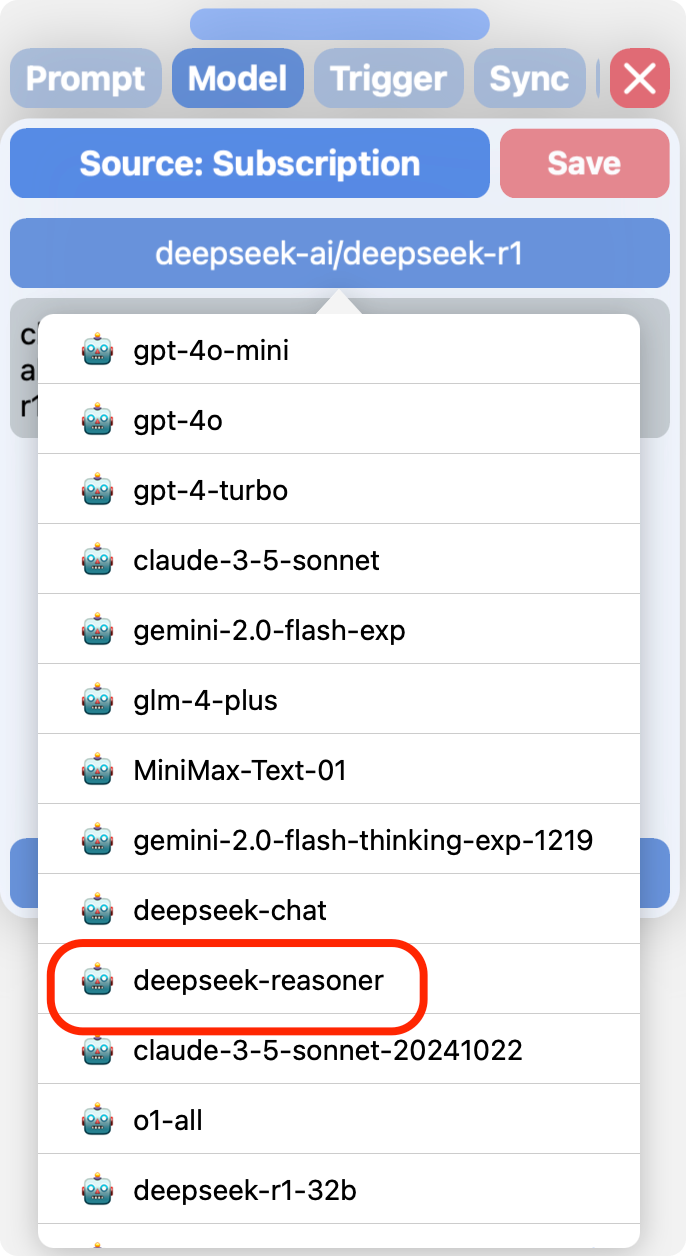

订阅用户使用

deepseek-reasoner模型(官方一折)

-

Deepseek 源:

-

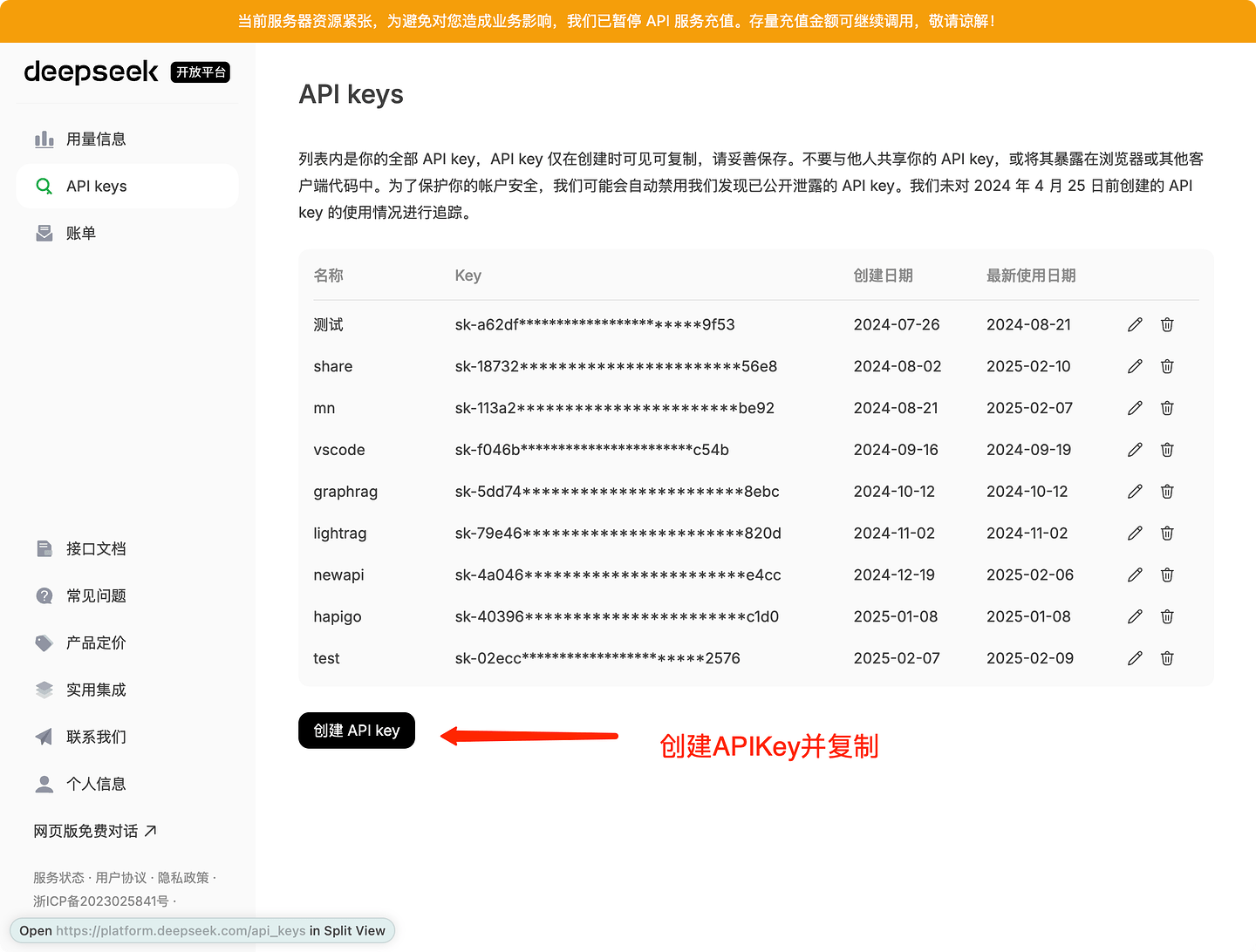

打开官方开放平台:DeepSeek

-

创建一个新的APIKey

-

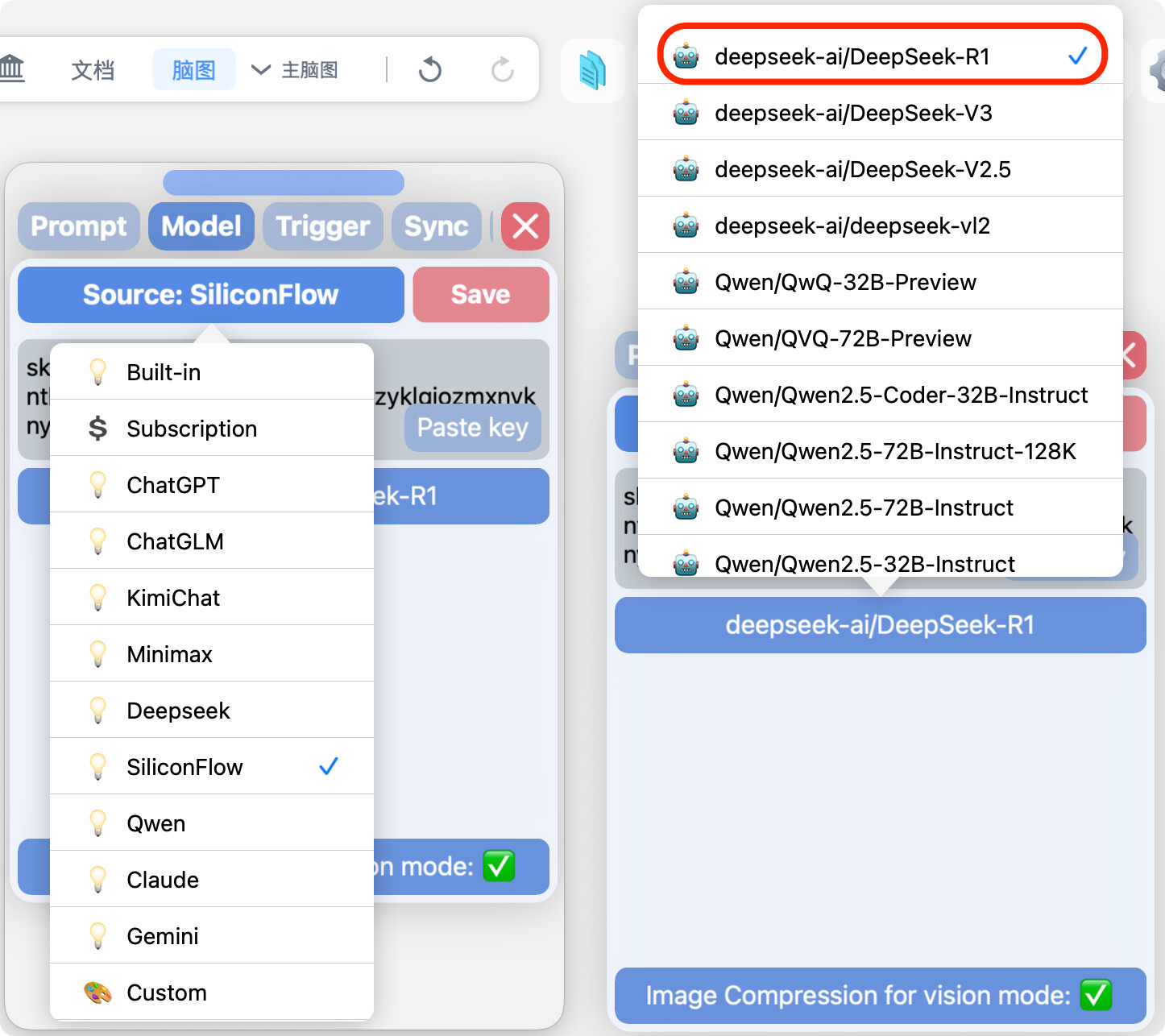

切换到deepseek源,配置好自己的apiKey后切换到

deepseek-reasoner -

完整URL:

https://api.deepseek.com/chat/completions

-

-

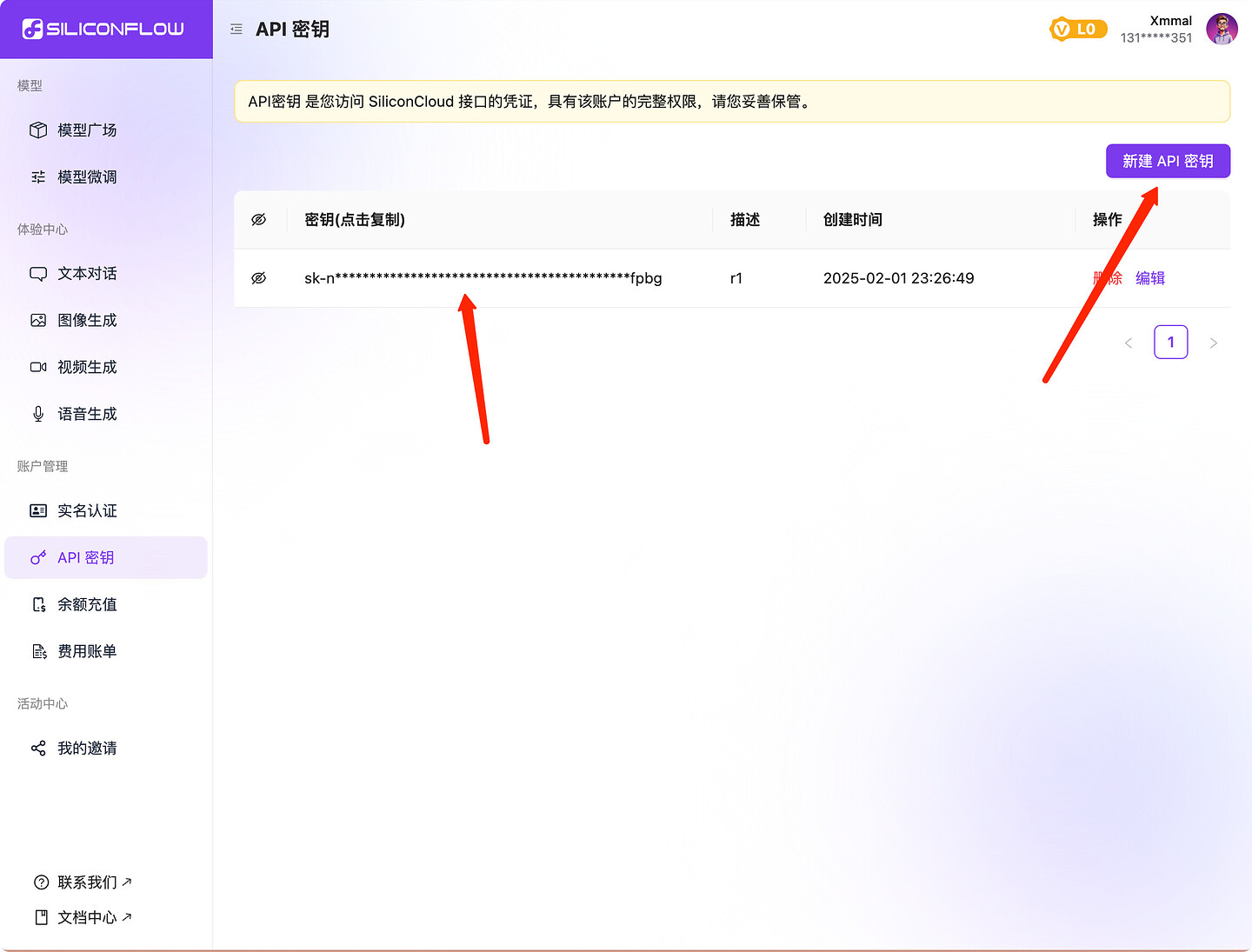

硅基流动:

-

阿里百炼

-

登录开通百炼并创建APIKey:阿里云登录 - 欢迎登录阿里云,安全稳定的云计算服务平台

-

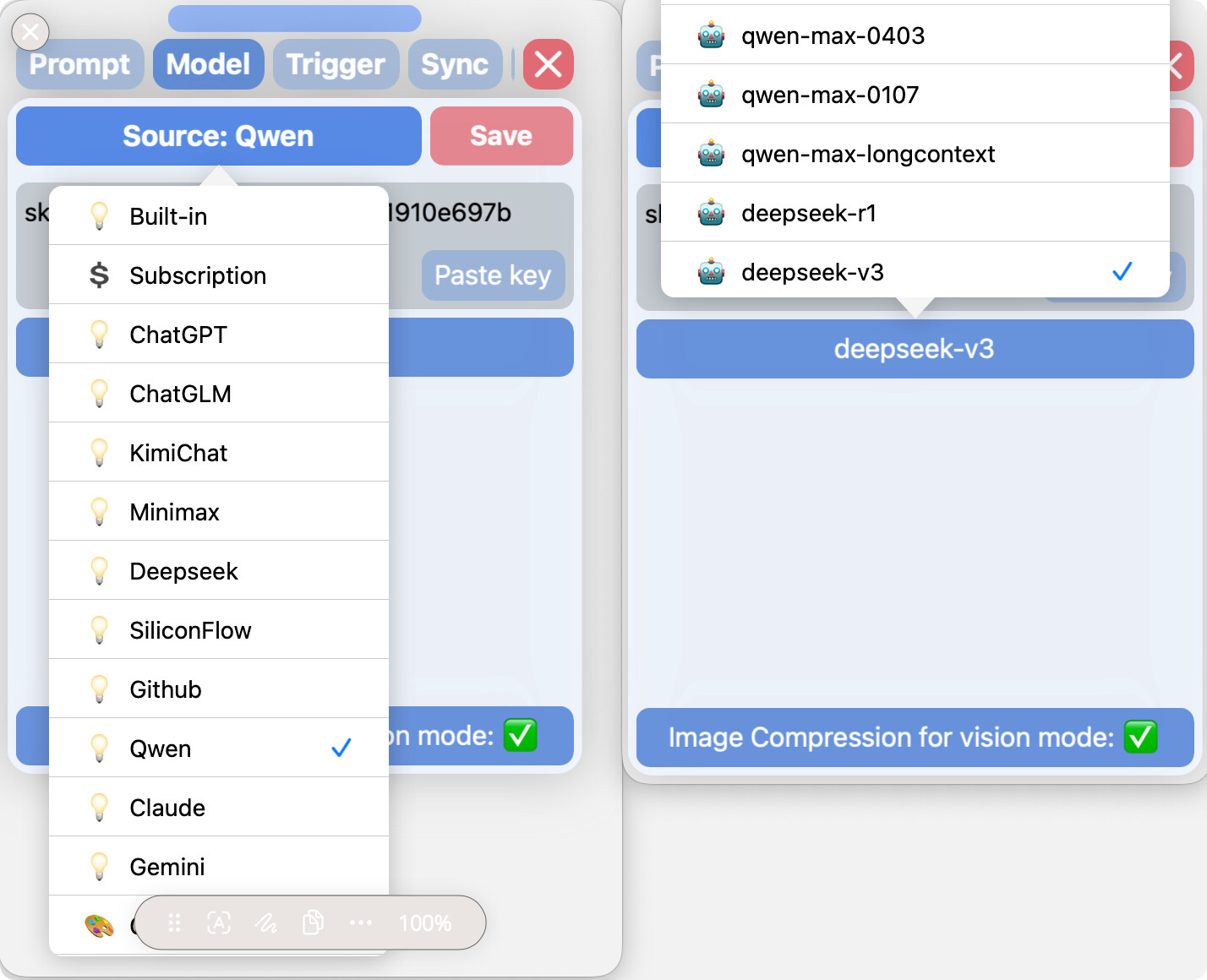

切换到Qwen源粘贴APIKey并选择

deepseek-r1(粘贴之后会自动保存,不需要点save按钮)

-

完整URL:

https://dashscope.aliyuncs.com/compatible-mode/v1/chat/completions

-

-

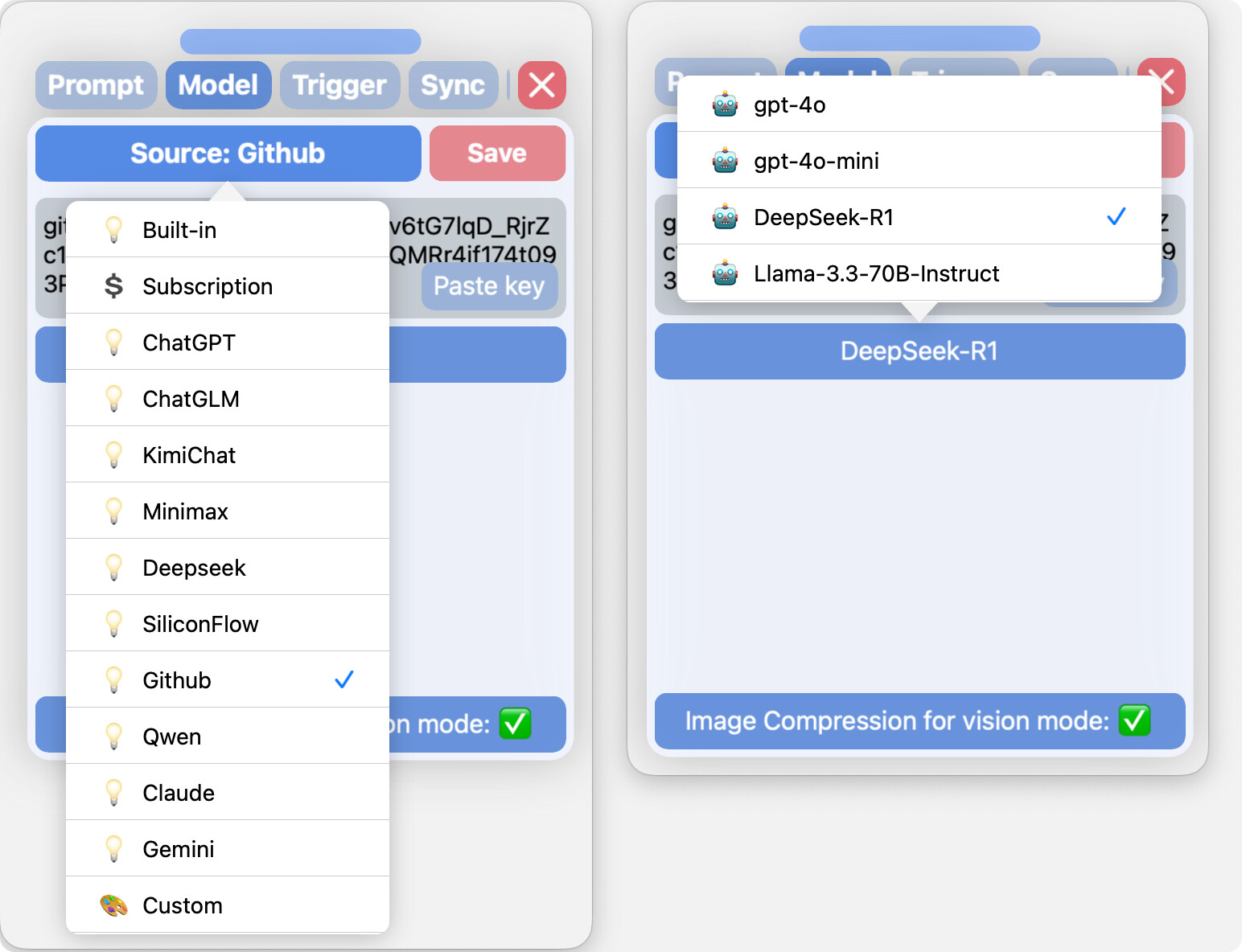

Github

-

登录Github并打开以下链接创建一个token(记得保存下来)

-

切换到Github源,粘贴APIKey,选择

DeepSeek-R1模型 -

完整URL:

https://models.inference.ai.azure.com/chat/completions

-

-

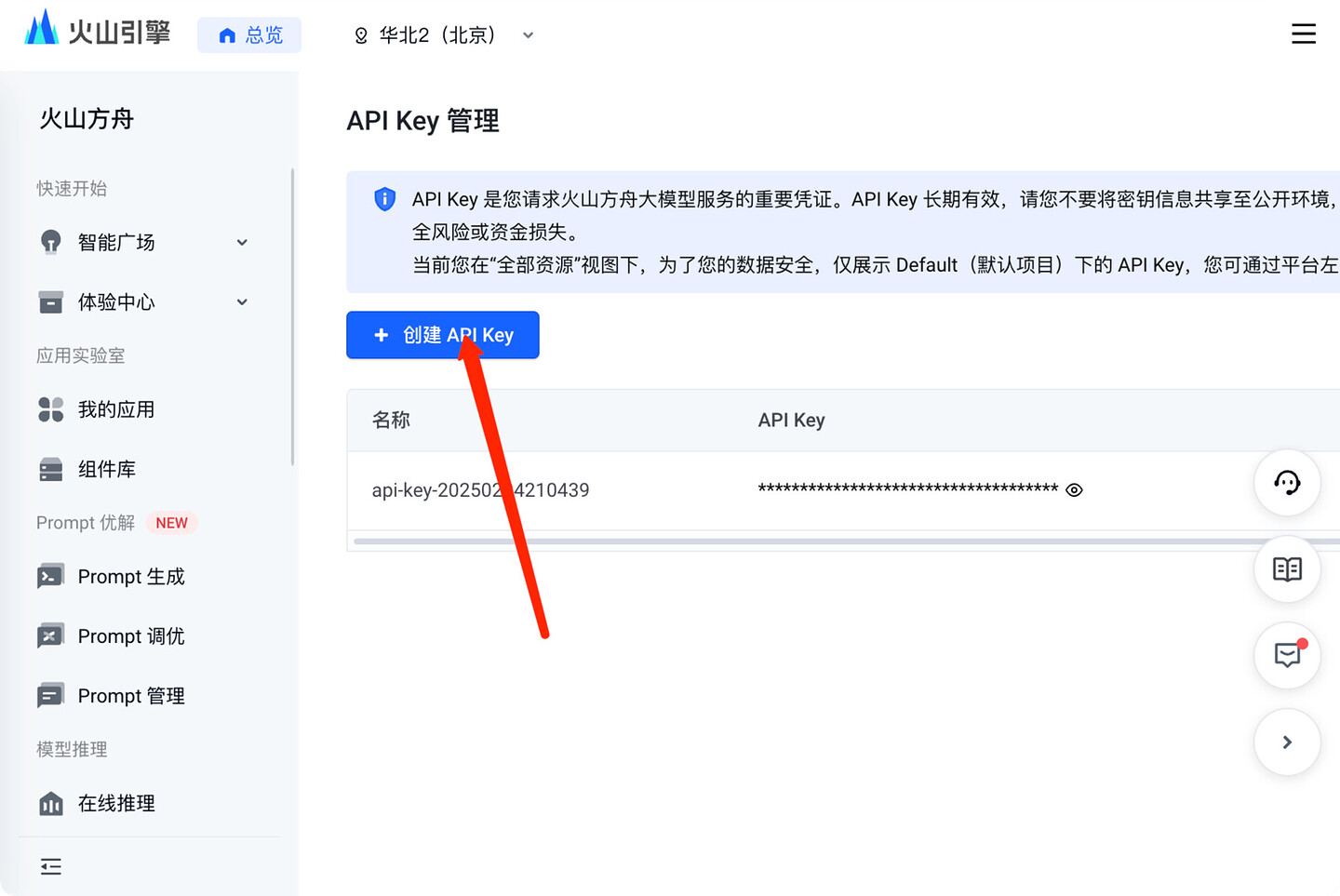

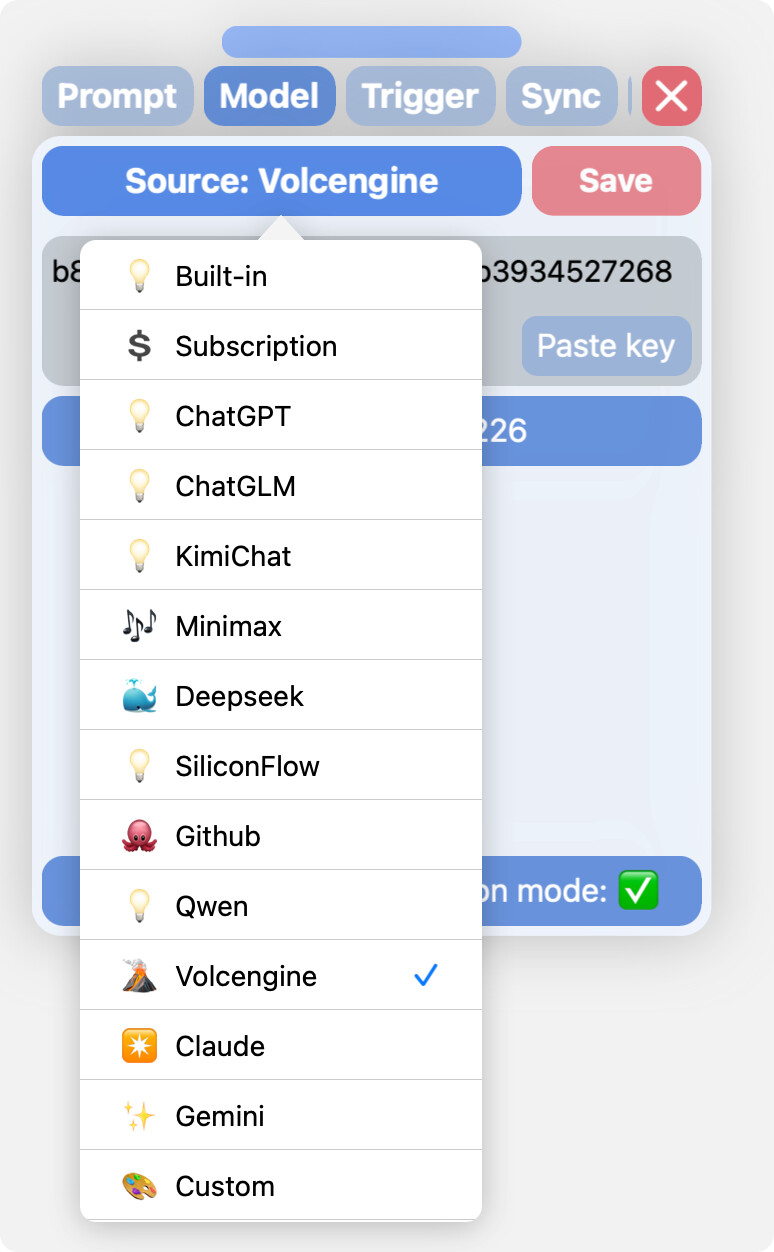

火山引擎

-

注册并登录:账号登录-火山引擎

-

通过这个链接注册并实名后赠送15元代金券(或使用邀请码:DAT5N2FY):邀请好友免费领大模型-火山引擎

-

获取APIKey:账号登录-火山引擎

-

在Custom源配置:

完整URL:

https://ark.cn-beijing.volces.com/api/v3/chat/completionsAPIKey: 前面得到的APIKey

Model:

deepseek-r1-250120 -

直接在对应的源配置(需要更新到0.2.4.alpha0220)

-

-

百度智能云

-

登录并获取APIKey(授权服务为千帆ModelBuilder):百度智能云

-

在Custom源配置:

完整URL:

https://qianfan.baidubce.com/v2/chat/completionsAPIKey: 前面得到的APIKey

Model:

deepseek-r1

-

-

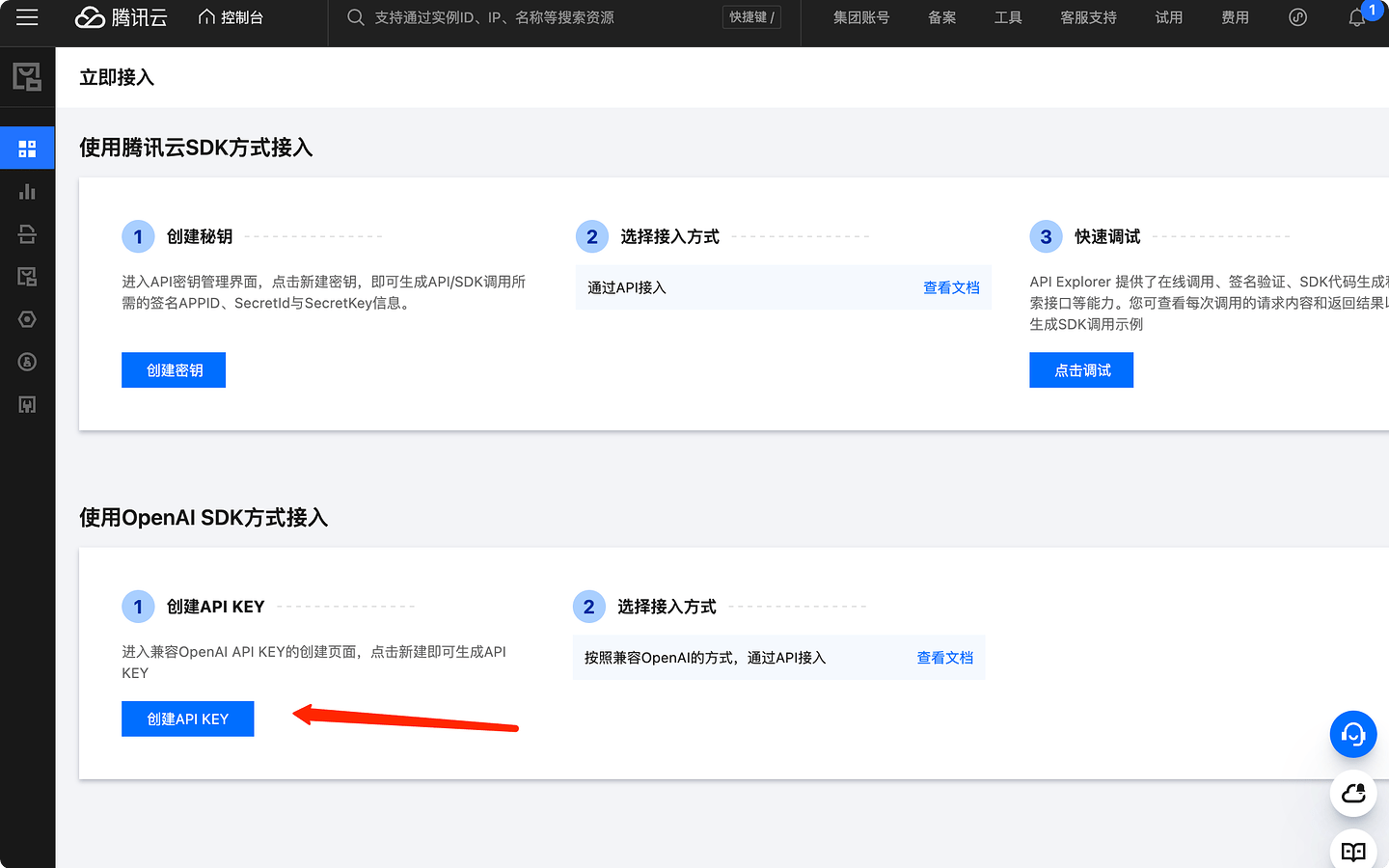

腾讯云

-

注册并登录: 登录 - 腾讯云

-

创建APIKey并复制

-

在Custom源配置:

完整URL:

https://api.lkeap.cloud.tencent.com/v1/chat/completionsAPIKey: 前面得到的APIKey

Model:

deepseek-r1

-

-

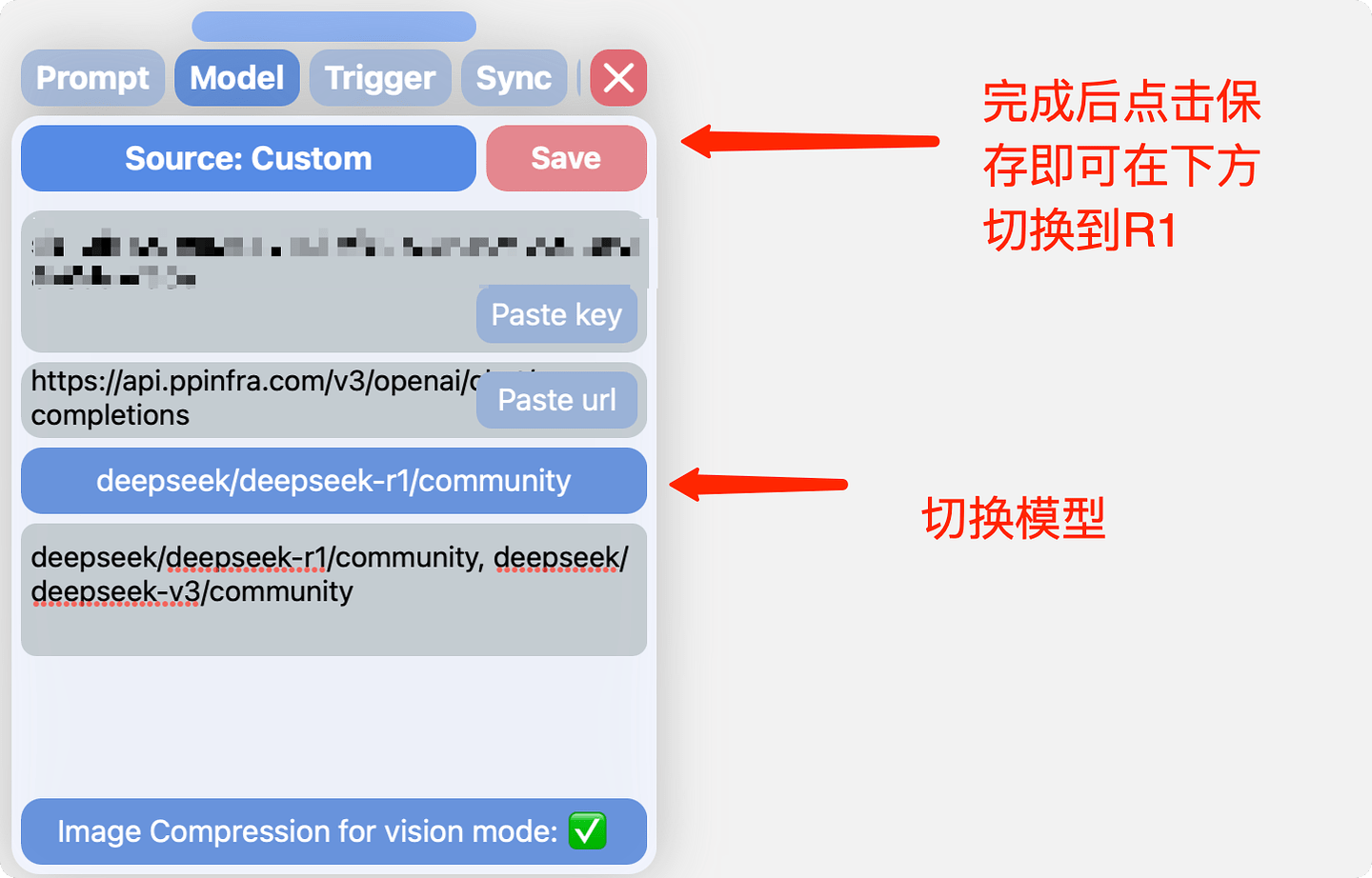

派欧算力云

-

注册送5元代金券,带以下邀请链接注册再送50

派欧算力云 - AI 云端一体化解决方案: 模型 API、Serverless、GPU 租赁 -

创建APIKey并复制

派欧算力云 - AI 云端一体化解决方案: 模型 API、Serverless、GPU 租赁 -

在Custom源配置:

完整URL:

https://api.ppinfra.com/v3/openai/chat/completionsAPIKey: 前面得到的APIKey

Model:

deepseek/deepseek-r1/community

-